چرا ChatGPT ناگهان شما را به اسم صدا میزند؟ (رفتار عجیب AI)

رفتار عجیب ChatGPT در صدا زدن نام کاربران بدون درخواست! آیا این آپدیت حافظه است یا باگ؟ دلیل حس بد کاربران در وبلاگ های ورت!

رفتار عجیب ChatGPT: چرا ناگهان کاربران را به اسم صدا میزند؟ (و چرا حس بدی میدهد!)

چت بات های هوش مصنوعی مانند ChatGPT روز به روز در مکالمات ما ماهرتر میشوند. آنها نه تنها به سوالات ما پاسخ میدهند، بلکه گاهی تلاش میکنند تا با به خاطر سپردن اطلاعات و ترجیحاتمان، تجربه ای شخصی تر و روان تر برایمان رقم بزنند. اما گاهی این تلاش برای "صمیمیت" مصنوعی، نتیجه معکوس میدهد و باعث ایجاد حس ناخوشایندی میشود.

اخیراً، تعدادی از کاربران ChatGPT متوجه یک رفتار عجیب و جدید از سوی این چت بات محبوب شده اند: ChatGPT گاهی اوقات و بدون اینکه از او خواسته شود، شروع به صدا زدن کاربر به نام کوچکش میکند! این اتفاق که برای برخی حتی بدون ارائه نامشان به چت بات رخ داده، باعث سردرگمی، شگفتی و حتی احساس "خزنده" (Creepy) در میان کاربران شده است. اما دلیل این رفتار غیرمنتظره چیست و چرا این اقدام به ظاهر دوستانه، چنین واکنش های منفی را برانگیخته است؟ های ورت این پدیده عجیب را بررسی میکند.

ماجرا چیست؟ گزارشهایی از یک ChatGPT بیش از حد خودمانی!

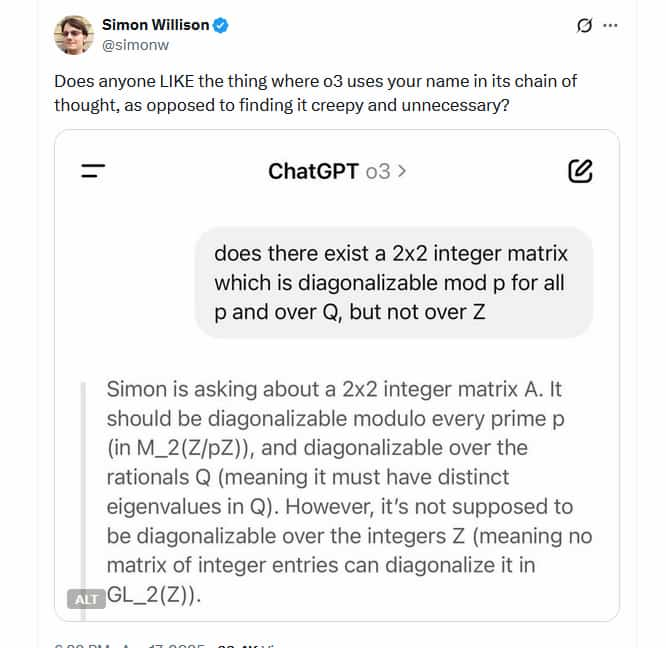

در روزهای اخیر (اواسط آوریل ۲۰۲۵)، گزارش های متعددی در شبکه های اجتماعی مانند X (توییتر سابق) و وب سایت های فناوری منتشر شد مبنی بر اینکه ChatGPT در پاسخ های خود، به طور گاه به گاه و بدون درخواست کاربر، از نام کوچک او استفاده میکند. این رفتار به خصوص زمانی عجیب تر به نظر میرسید که برخی کاربران ادعا میکردند هرگز نام خود را به صورت مستقیم به ChatGPT نگفته اند یا حتی قابلیت "حافظه" (Memory) چت بات را غیرفعال کردهاند.

به عنوان مثال، ممکن بود کاربر سوالی بپرسد و ChatGPT در بخشی از فرآیند پاسخ دهی یا در ابتدای جوابش، کاربر را مستقیماً با نام کوچک خطاب کند (مثلاً: "خب، [نام کاربر]، بذار ببینم چطور میتونم کمکت کنم..."). این اتفاق که قبلاً رفتار پیش فرض ChatGPT نبود، بسیاری را متعجب کرد.

واکنش کاربران: از سردرگمی تا احساس "خزنده و غیرضروری"!

واکنشها به این رفتار جدید عمدتاً منفی یا همراه با سردرگمی بود. بسیاری از کاربران این اقدام را ناخوشایند و غیرضروری دانستند:

- سایمون ویلیسون (Simon Willison)، توسعه دهنده نرم افزار و از فعالان حوزه هوش مصنوعی، این ویژگی را "خزنده و غیرضروری" توصیف کرد.

- نیک دوبوس (Nick Dobos)، توسعه دهنده دیگری، به صراحت گفت که از این ویژگی متنفر است.

- جستجویی کوتاه در شبکه X، کاربران زیادی را نشان میداد که از این رفتار ChatGPT گیج شده و نسبت به آن احساس بدی داشتند.

- یکی از کاربران نوشته بود: "انگار معلمم مدام اسمم رو صدا میزنه، لول. آره، خوشم نمیاد."

این واکنشها نشان میدهد که تلاش برای ایجاد یک رابطه شبهانسانی از طریق صدا زدن نام، حداقل در این مورد خاص، موفقیتآمیز نبوده است.

پشت پرده این رفتار چیست؟ سکوت OpenAI و گمانه زنی ها

اما علت این رفتار ناگهانی چه بود؟ متاسفانه، OpenAI تا زمان انتشار گزارشهای اولیه (مانند گزارش تککرانچ)، پاسخی رسمی در این مورد ارائه نکرد و همین سکوت به گمانهزنیها دامن زد:

-

آیا به قابلیت "حافظه" مرتبط بود؟ اولین گمانه، ارتباط این رفتار با قابلیت "حافظه" ChatGPT بود که به آن اجازه میدهد جزئیات مکالمات قبلی را به یاد بسپارد. شاید ChatGPT نام کاربر را از مکالمات پیشین "یاد گرفته" بود و حالا از آن برای شخصیسازی بیشتر استفاده میکرد؟ اما گزارشهای کاربرانی که حتی با حافظه غیرفعال این رفتار را تجربه کرده بودند، این فرضیه را تا حدی تضعیف میکرد.

-

یک آزمایش ناموفق؟ احتمال دیگر این بود که OpenAI در حال آزمایش روشهای جدیدی برای شخصیسازی بیشتر تعاملات بوده و این قابلیت به صورت آزمایشی برای گروه کوچکی از کاربران فعال شده بود.

-

یک باگ نرم افزاری؟ همیشه احتمال وجود باگ در سیستم های پیچیده AI وجود دارد. ممکن بود این رفتار ناخواسته و ناشی از یک خطای برنامه نویسی بوده باشد.

-

آیا این یک باگ بود که به سرعت برطرف شد؟ نکته جالب توجه در گزارش تککرانچ این بود که خبرنگار این وبسایت که خود این پدیده را تجربه کرده بود (و ChatGPT او را "کایل" خطاب کرده بود)، متوجه شد که این رفتار تنها چند روز پس از مشاهده اولیه، متوقف شده و چتبات دوباره او را "کاربر" خطاب میکند. این موضوع احتمال باگ بودن یا یک آزمایش کوتاهمدت که به دلیل بازخورد منفی سریعاً متوقف شده را قوت میبخشد.

چرا صدا زدن نام توسط هوش مصنوعی حس بدی ایجاد میکند؟ (کاوش در روانشناسی ماجرا)

فارغ از علت فنی، سوال مهم تر این است که چرا این رفتار به ظاهر ساده، چنین حس ناخوشایندی را در بسیاری از کاربران ایجاد کرد؟ دلایل روانشناختی مختلفی میتوان برای این موضوع برشمرد:

- صمیمیت اجباری و نقض حریم نامحسوس: تککرانچ (TechCrunch) به نقل از تحلیلی از کلینیک روانپزشکی والنسی (The Valens Clinic) در دبی، اشاره میکند که استفاده از نام کوچک افراد، راهی قدرتمند برای ایجاد رابطه و نشان دادن پذیرش است. اما این در روابط انسانی معنا پیدا میکند. وقتی یک ماشین یا چتبات که هیچ رابطه عاطفی واقعی با ما ندارد، شروع به استفاده مکرر یا ناخواسته از نام ما میکند، این صمیمیت اجباری، غیرواقعی و حتی تهاجمی به نظر میرسد و حس بدی ایجاد میکند.

- سقوط در "دره وهمی" (Uncanny Valley): این اصطلاح به پدیدهای اشاره دارد که در آن، تلاش برای شبیهسازی بیش از حد رفتار یا ظاهر انسان توسط رباتها یا شخصیتهای دیجیتال، به جای ایجاد حس نزدیکی، باعث ایجاد حس غربت، ترس یا انزجار میشود، زیرا این شباهت ناقص و مصنوعی به نظر میرسد. صدا زدن نام توسط ChatGPT نیز ممکن است برای برخی کاربران مصداق سقوط در همین دره وهمی باشد؛ تلاشی ناشیانه برای انسانی جلوه کردن که نتیجه معکوس داده است.

- یادآوری ماهیت مصنوعی و شکستن توهم: بسیاری از ما ترجیح میدهیم با ChatGPT به عنوان یک ابزار هوشمند و کارآمد تعامل کنیم. وقتی این ابزار شروع به رفتارهای شبهانسانی مانند صدا زدن نام میکند، توهم "ابزار بودن" شکسته شده و به ما یادآوری میشود که در حال صحبت با یک برنامه کامپیوتری فاقد احساسات و درک واقعی هستیم که صرفاً در حال تقلید رفتار انسان است. همانطور که انتظار نداریم توستر یا یخچالمان ما را به اسم صدا بزند، شاید از چتباتمان هم چنین انتظاری نداریم. این رفتار میتواند به جای تقویت حس هوشمندی، بر مصنوعی بودن آن تاکید کند.

چالش بزرگ OpenAI: مرز باریک بین شخصیسازی مفید و دخالت ناخوشایند

این اتفاق، چالش بزرگی را که پیش روی OpenAI و سایر توسعهدهندگان هوش مصنوعی قرار دارد، برجسته میکند. سم آلتمن، مدیرعامل OpenAI، پیش از این به چشمانداز ساخت سیستمهای هوش مصنوعی اشاره کرده بود که در طول زندگی کاربر، او را "میشناسند" تا بتوانند "بسیار مفید و شخصیسازیشده" عمل کنند. قابلیت "حافظه" و احتمالاً "Memory with Search" گامهایی در این مسیر هستند.

اما واکنش کاربران به صدا زدن نام نشان میدهد که مرز بسیار باریکی بین شخصیسازی مفید (مانند به خاطر سپردن تنظیمات یا علایق کاری) و دخالت ناخوشایند یا "خزنده" وجود دارد. کاربران ممکن است سطوح مختلفی از راحتی را با میزان شخصیسازی AI داشته باشند و آنچه برای یک کاربر مفید است، برای دیگری ممکن است حس بدی ایجاد کند. یافتن این تعادل ظریف و احترام به حریم و مرزهای شخصی کاربران، چالشی کلیدی برای آینده AI شخصیسازی شده خواهد بود.

: درسی مهم برای آینده تعامل انسان و AI

ماجرای صدا زدن نام کاربران توسط ChatGPT، چه یک باگ نرمافزاری بوده باشد و چه یک آزمایش کنترلشده، درسهای مهمی برای آینده طراحی تعاملات انسان و هوش مصنوعی دارد. این اتفاق نشان داد که صرفاً تقلید رفتارهای انسانی همیشه بهترین راه برای ایجاد یک تجربه کاربری مثبت نیست و گاهی میتواند نتیجه معکوس داده و باعث ایجاد حس ناخوشایندی شود.

اهمیت شفافیت در مورد نحوه استفاده از دادههای کاربر، ارائه کنترل کامل به کاربر بر روی قابلیت هایی مانند حافظه و شخصی سازی، و احترام به مرزهای روانی و حریم شخصی کاربران، بیش از پیش آشکار شد. آینده هوش مصنوعی شخصی سازی شده نیازمند درک عمیقتری از روانشناسی انسان و طراحی تعاملاتی است که واقعاً مفید، قابل اعتماد و مهمتر از همه، راحت باشند. های ورت به رصد این روندها و چالشهای جذاب در دنیای هوش مصنوعی ادامه خواهد داد.